Fora de um laboratório de paredes envidraçadas nos arredores de Londres, o futuro soa estranhamente banal. As máquinas de venda automática zumbem. Os cartões de acesso apitam. Um investigador de hoodie leva um portátil debaixo de um braço e uma sandes de supermercado no outro. Lá dentro, porém, está a formar-se outro tipo de ruído: linhas de código a correr em racks de GPUs, modelos a treinar com linguagem humana, imagens, estratégias, padrões. O tipo de modelos que em breve poderá pensar melhor do que os seus criadores.

Ninguém no corredor está em pânico. As pessoas fazem piadas na fila do café, queixam-se da impressora, comparam planos para o fim de semana. E, no entanto, como diz discretamente um investigador de referência em segurança de IA, o mundo “pode não ter tempo” para se preparar para o que aí vem.

A parte mais inquietante é que tão poucas pessoas fora destes edifícios sequer sabem que perguntas fazer.

“Estamos a avançar mais depressa do que o nosso manual de segurança consegue acompanhar”

Numa tarde cinzenta de terça-feira, o aviso cai como um peso numa sala de reuniões apertada. Um investigador de referência em segurança de IA - do tipo cujo trabalho molda briefings de política e reuniões à porta fechada em Washington e Bruxelas - levanta os olhos de um slide cheio de curvas. O gráfico mostra as capacidades da IA a dispararem. A linha da regulação e das ferramentas de segurança fica muito atrás.

“Podemos não ter tempo para nos prepararmos para toda a gama de riscos”, dizem, deixando o silêncio prolongar-se. O slide não grita. Apenas mostra um fosso que, ano após ano, se transforma num abismo.

Para perceber o que querem dizer, não precisa de ficção científica. Precisa de um exemplo simples. Em 2019, os grandes modelos de linguagem ainda eram demonstrações de nicho. Em 2022, já escreviam e-mails, trabalhos escolares, código básico. Em 2024, sistemas de fronteira conseguiam desenhar moléculas, depurar programas complexos, redigir documentos ao estilo jurídico, imitar um estilo de escrita depois de alguns parágrafos.

Cada salto apanhou o público de surpresa. As escolas improvisaram. As empresas correram a reescrever políticas. Os governos redigiram documentos de discussão enquanto as equipas de produto lançavam novas funcionalidades todos os meses. A velocidade parecia menos um roteiro e mais uma série de saltos por cima de uma fenda a alargar-se.

O ponto do investigador é brutalmente simples: os sistemas de segurança crescem de forma linear, a cultura e a lei evoluem devagar, mas as capacidades da IA dão picos. O desalinhamento não é apenas sobre “superinteligência descontrolada”; é também sobre milhares de falhas desorganizadas, aborrecidas, à escala. Uma ferramenta hospitalar discretamente enviesada contra um grupo minoritário. Um modelo que ajuda um actor solitário a refinar uma ideia de bioengenharia. Um sistema de trading autónomo que optimiza o lucro de formas que ninguém nota até o dano acontecer.

Quando liga esses riscos a um mundo já esticado por geopolítica, stress climático e extremismo online, a questão do calendário deixa de ser abstracta e começa a soar a contagem decrescente.

Porque “não ter tempo” parece mais próximo do que pensamos

Há um tipo específico de inquietação que aparece quando se fala, em off, com quem constrói estes sistemas. Estão orgulhosos do que estão a criar - e assustados com o que pode passar pelas brechas. Um engenheiro descreve o envio de um novo modelo como “soltar um animal selvagem com uma coleira GPS e esperar que a vedação aguente”.

Num quadro branco, alguém rabiscou: “O que acontece quando isto consegue agir, e não apenas falar?” Ninguém apagou. Fica ali, meio piada, meio alarme.

Já tivemos pequenos vislumbres do que acontece quando o mundo não está pronto. Algoritmos de recomendação empurraram a política para novos extremos mais depressa do que as leis ou os hábitos mediáticos conseguiram acompanhar. Ferramentas de deepfake ultrapassaram a capacidade dos tribunais para responder a imagens não consentidas. Mercados de criptoactivos incharam e rebentaram enquanto os reguladores tentavam perceber sequer o que estavam a ver.

Não é que a IA vá copiar essas histórias exactamente. É que o mesmo padrão se repete: primeiro a conveniência e a novidade, depois as guardas de segurança. E, por vezes, esse “depois” nunca chega realmente.

O investigador principal que avisa que podemos não ter tempo não está a imaginar um único momento de “apocalipse da IA”. Está a imaginar ondas sobrepostas de risco: phishing sofisticado à escala industrial, descoberta automatizada de vulnerabilidades de software, ferramentas de desenho biológico habilitadas por IA, chatbots persuasivos que conseguem atingir os medos das pessoas com uma precisão arrepiante.

Se sistemas muito capazes chegarem mais cedo do que o esperado - digamos, em cinco a dez anos em vez de trinta - o nosso kit actual de comissões de ética, compromissos voluntários e reguladores com pouco pessoal parecerá sacos de areia contra a maré a subir. O medo real não é apenas o que a IA consegue fazer. É o que os humanos farão com a IA quando as regras são fracas e os incentivos são afiados.

Como é, na prática, preparar-se na vida real

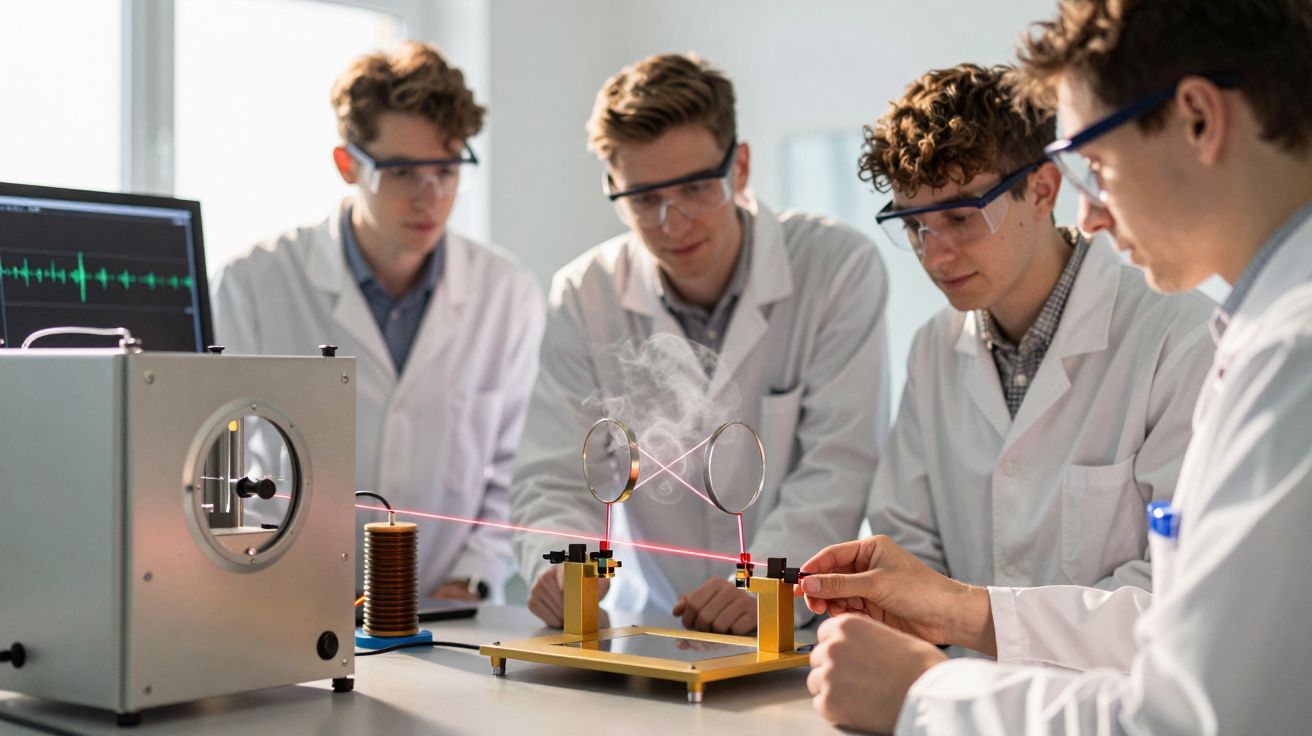

Preparação, na boca dos decisores políticos, soa muitas vezes a slogan vago. Dentro dos laboratórios e das equipas de segurança, é mais concreta. Há red-teamers que tentam activamente quebrar modelos, levando-os a revelar capacidades perigosas. Há investigadores de alinhamento a construir formas de a IA seguir valores humanos, e não apenas instruções humanas. Há equipas de avaliação a fazer testes de stress para ver o que um sistema fará em casos-limite.

Num ecrã grande, correm cenário após cenário: gerar código para malware, responder a perguntas sobre protocolos laboratoriais, aconselhar como escapar à supervisão. Não estão a tentar inspirar pânico. Estão a tentar mapear a beira do precipício antes de lá cairmos.

Fora desses laboratórios, preparar-se pode ser tão simples como mudar a forma como tomamos decisões sobre IA. As empresas podem traçar linhas vermelhas sobre onde a IA nunca é usada - por exemplo, em diagnósticos médicos finais ou decisões legais de alto risco - sem supervisão humana robusta. As escolas podem deixar de fingir que a IA não existe e, em vez disso, ensinar a colaborar com ela, a questioná-la e a detectar quando está a inventar.

Sejamos honestos: quase ninguém faz isto no dia-a-dia. A maioria das pessoas copia e cola um prompt, passa os olhos pela resposta e segue em frente. É humano. E é exactamente assim que danos subtis passam despercebidos e se tornam normais.

Entre investigadores, cresce a pressão por aquilo a que um deles chama “heroísmo aborrecido”: construir ferramentas aborrecidas como registos de auditoria, sistemas de reporte de incidentes e registos de modelos antes da crise. Não vira tendência nas redes sociais, mas importa.

“O cenário assustador não é um robô overlord malvado”, disse-me um cientista sénior de segurança. “São milhares de sistemas poderosos integrados em infra-estruturas críticas, todos optimizados para objectivos de curto prazo, sem que ninguém compreenda realmente o seu comportamento combinado.”

- Os governos precisam de testes independentes a modelos de fronteira, não apenas das alegações das empresas.

- As tecnológicas precisam de deveres legais quando implementam IA de alto risco, não apenas promessas de relações públicas.

- Os cidadãos precisam de literacia básica em IA, tal como aprendemos em tempos segurança rodoviária ou higiene alimentar.

Viver com a contagem decrescente - sem ficar paralisado

A nível pessoal, toda esta conversa de “não há tempo” pode facilmente desencadear uma de duas reacções: negação ou paralisia. Ou encolhe os ombros e diz: “Andam há anos a avisar sobre riscos tecnológicos”, ou passa a noite a deslizar em threads sobre risco existencial e sente um nó frio no estômago. Nenhuma das duas ajuda muito.

Numa noite chuvosa em Berlim, vi um grupo de jovens fundadores e activistas discutir isto ao som de noodles baratos. Um insistia que a única resposta racional era regulação global urgente. Outro resmungava que os governos se movem demasiado devagar, por isso estamos condenados. Um terceiro só queria saber o que dizer à irmã mais nova na universidade.

Todos já vivemos aquele momento em que uma nova tecnologia nos cai nas mãos antes de termos etiqueta, normas ou regras para a lidar. A primeira vez que os smartphones apareceram nas salas de aula. A primeira vez que uma rede social transformou mexericos privados em drama público. A primeira vez que um vídeo deepfake surgiu no feed e teve de olhar duas vezes.

A IA, sobretudo na fronteira, é essa história em fast-forward. O verdadeiro peso emocional de “podemos não ter tempo” não é para esmagar. É para abanar. Para nos tirar da suposição preguiçosa de que há adultos algures a tratar disto. Porque, muitas vezes, não há adultos. Apenas nós, a aprender em público.

Falemos verdade por um momento: se está a ler isto no telemóvel entre duas notificações, já está a viver dentro de uma experiência gigante de IA. Motores de recomendação escolhem o que vê. Filtros de spam escolhem o que não vê. Sistemas futuros vão moldar empregos, eleições, talvez até decisões de guerra.

Por isso, a pergunta que este investigador está realmente a fazer tem menos a ver com calendários abstractos e mais com agência. Que parte deste futuro estamos dispostos a subcontratar a um punhado de laboratórios, investidores e equipas de segurança?

E que parte estamos dispostos a arrastar para a luz do dia - confusa, política e contestada - enquanto ainda há tempo para a discutir?

| Ponto-chave | Detalhe | Interesse para o leitor |

|---|---|---|

| Aceleração das capacidades | Os modelos avançam mais depressa do que as leis, as normas e as ferramentas de segurança | Perceber porque é que os avisos sobre a falta de tempo aparecem por todo o lado |

| Riscos concretos, não apenas sci‑fi | Phishing avançado, bio-design, enviesamentos sistémicos, detecção de falhas de software | Ligar a IA a ameaças tangíveis na vida quotidiana e profissional |

| Preparação distribuída | Testes independentes, guardas de segurança fortes, cultura de “higiene de IA” para todos | Saber o que governos, empresas e indivíduos podem fazer já |

FAQ

- Isto é sobre robôs assassinos a dominar o mundo? Não exactamente. A maioria dos investigadores preocupados com calendários de IA fala de riscos sistémicos: desinformação à escala, infra-estruturas críticas dependentes de sistemas opacos e modelos que ajudam maus actores a fazer dano de forma mais eficiente.

- O que significa, na prática, “podemos não ter tempo”? Significa que as capacidades da IA podem atingir níveis perigosos antes de os nossos testes de segurança, regulamentos e coordenação global estarem suficientemente maduros para as gerir de forma fiável.

- Quão perto, afinal, é que os especialistas receiam? Há enorme incerteza, mas muitos investigadores sérios tratam agora os próximos 5–15 anos como uma janela em que podem surgir sistemas muito poderosos, e não como um futuro distante de um século.

- A segurança em IA não é apenas uma desculpa para abrandar a inovação? Algumas pessoas usam-na assim, mas a maioria dos investigadores de segurança trabalha dentro dos mesmos laboratórios que constroem estes modelos. Estão a tentar evitar cenários em que uma única falha apaga os benefícios para todos.

- O que pode, de facto, fazer uma pessoa comum? Aprender literacia básica em IA, apoiar regulação transparente, questionar onde a IA é usada em serviços de que depende e pressionar o seu local de trabalho ou escola a adoptar regras claras e públicas para o uso de IA, em vez de avançar às cegas.

Comentários

Ainda não há comentários. Seja o primeiro!

Deixar um comentário